One-Shot vs Few-Shot Prompting – wann welche Methode überzeugt

Large Language Models wie GPT-4 lassen sich flexibel einsetzen – vorausgesetzt, sie bekommen die richtigen Anweisungen.

Eine entscheidende Rolle spielt dabei die Art, wie Beispiele in den Prompt eingebunden werden.

Soll das Modell mit einem einzigen Beispiel arbeiten (One Shot)? Oder braucht es mehrere, um die Aufgabe zu verstehen (Few Shot)?

Die Wahl der richtigen Strategie hat direkte Auswirkungen auf die Qualität der Ergebnisse – besonders bei komplexeren oder sensiblen Aufgaben.

Dieser Artikel bietet einen klaren Überblick über die Unterschiede zwischen One-Shot und Few-Shot Prompting, zeigt typische Einsatzszenarien und erklärt, worauf es bei der praktischen Anwendung ankommt.

Für umfassendere Vergleiche und detaillierte Anleitungen zu weiteren Prompting-Techniken, schau mal in meinem Prompt Engineering Hub vorbei.

Was heißt eigentlich „Shot“?

In der Arbeit mit großen Sprachmodellen begegnet man schnell den Begriffen Zero Shot, One Shot und Few Shot Prompting.

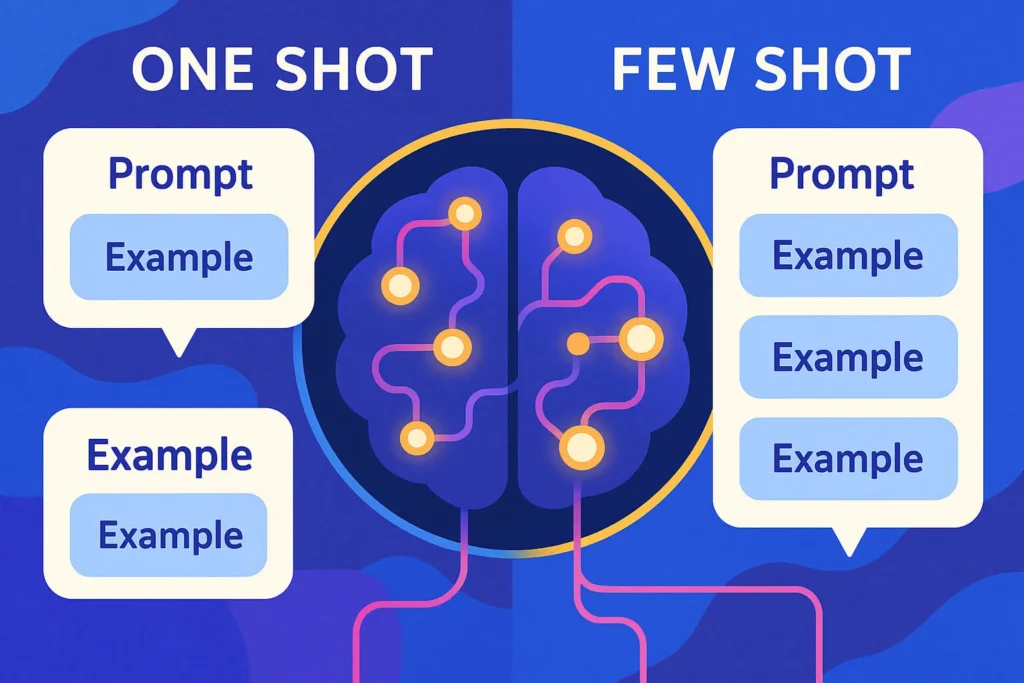

Alle drei beziehen sich auf die Anzahl von Beispielen, die einem Modell im Prompt mitgegeben werden – also direkt im Texteingabefeld, bevor die eigentliche Aufgabe gestellt wird.

Der Begriff „Shot“ steht dabei ganz einfach für ein Beispiel – im Sinne von: „So sieht eine typische Eingabe mit der gewünschten Ausgabe aus.“

Die drei Grundformen:

- Zero Shot Prompting

Hier bekommt das Modell kein Beispiel, sondern nur eine Anweisung. Es muss auf Basis seines allgemeinen Wissens verstehen, was zu tun ist. - One Shot Prompting

Es wird ein einziges Beispiel mitgegeben. Das Modell kann daraus ableiten, wie die Aufgabe funktioniert – zumindest im Idealfall. - Few Shot Prompting

Hier bekommt das Modell mehrere Beispiele (typischerweise 2–10), um Muster zu erkennen und die Aufgabe besser zu verstehen.

Alle drei Varianten sind Formen des sogenannten In-Context Learning. Das bedeutet: Das Modell lernt nicht langfristig, sondern nur innerhalb des aktuellen Prompts.

Es „liest“ die Beispiele und versucht, daraus abzuleiten, was es tun soll – ganz ohne Nachtraining oder Anpassung des Modells selbst.

So sieht das konkret aus (Mini-Beispiel):

Angenommen, die Aufgabe lautet: Ist der folgende Satz positiv oder negativ gemeint?

Zero Shot Prompting

Bewerte den folgenden Satz als "positiv" oder "negativ":

"Ich finde das absolut großartig."

➡️ Das Modell muss aus der Anweisung und seinem Weltwissen schließen, was gemeint ist.

One Shot Prompting

Satz: "Das war eine schreckliche Erfahrung."

Label: negativ

Satz: "Ich finde das absolut großartig."

Label:

➡️ Das Modell bekommt ein Beispiel und soll anhand dessen das Format und die Aufgabe erschließen.

Few Shot Prompting

Satz: "Das war eine schreckliche Erfahrung."

Label: negativ

Satz: "Das hat mich wirklich gefreut."

Label: positiv

Satz: "Ich finde das absolut großartig."

Label:

➡️ Zwei Beispiele helfen dem Modell, die Polarität zu erkennen und die Ausgabe konsistenter zu gestalten.

Je mehr solcher Beispiele eingebunden werden, desto besser kann das Modell typische Muster, Tonalität und Format ableiten.

Aber: Das funktioniert nur, wenn die Beispiele gut gewählt und klar formatiert sind – dazu später mehr.

Im nächsten Abschnitt schauen wir uns an, wie One Shot Prompting im Detail funktioniert – und warum ein einzelnes Beispiel manchmal Wunder wirken kann.

One Shot Prompting – Ein Beispiel reicht, oder?

Beim One Shot Prompting bekommt das Sprachmodell genau ein Beispiel, um zu verstehen, was von ihm erwartet wird.

Dieses Beispiel besteht aus einer typischen Eingabe mitsamt der gewünschten Ausgabe – also z. B. einem Satz mit zugehöriger Kategorie, einer Frage mit passender Antwort oder einem Text mit korrekter Formatierung.

Der Sinn dahinter: Das Modell soll aus diesem einen Beispiel die Struktur und Zielsetzung der Aufgabe ableiten – ohne dass man die Regeln oder Kriterien explizit erklären muss.

Wann ist One Shot sinnvoll?

One Shot Prompting funktioniert besonders gut bei Aufgaben, die…

- ein klares Format haben (z. B. „Frage – Antwort“, „Text – Label“)

- wenig Interpretationsspielraum lassen

- in sich konsistent sind (z. B. immer dasselbe Thema, dieselbe Sprachebene)

- ein Beispiel wirklich repräsentativ abbilden kann

Typische Anwendungsfälle sind z. B.:

- Klassifikation von Texten in zwei oder drei Kategorien

- Formatkonvertierung (z. B. Freitext in Listenform)

- Extraktion strukturierter Informationen aus klaren Sätzen

- Kurze Rewrites nach Vorlage (z. B. „formuliere freundlicher“)

Aber: Ein Beispiel kann auch täuschen

Die Grenzen von One Shot Prompting zeigen sich schnell, wenn…

- das Beispiel nicht eindeutig ist oder mehrere Interpretationen zulässt

- die Aufgabe inhaltlich komplex ist (z. B. ironische Sprache, ambivalente Aussagen)

- das Beispiel nicht gut zum restlichen Input passt

- das Modell den Stil oder die Intention nicht aus einem einzigen Beispiel korrekt ableiten kann

Gerade bei Aufgaben mit Nuancen oder inhaltlicher Varianz kann ein einziges Beispiel sogar in die Irre führen.

Dann trifft das Modell falsche Annahmen – etwa, dass bestimmte Formulierungen immer ein bestimmtes Label bedeuten.

Beispiel: Strukturierte Ausgabe mit einem Beispiel

Aufgabe: Extrahiere aus einem Freitext Name, Firma und Rolle einer Person.

Prompt:

Beispiel:

"Ich hatte gestern ein gutes Gespräch mit Lisa König von Brightlabs. Sie ist dort für Strategie und Kommunikation zuständig."

→ Name: Lisa König

→ Firma: Brightlabs

→ Rolle: Strategie und Kommunikation

Text:

"Letzte Woche traf ich auf der Konferenz Daniel Weber, der bei Mindset Consulting im Bereich Organisationsentwicklung arbeitet."

→ Name:

➡️ Das Modell wird nun aufgefordert, die Struktur des Beispiels auf den neuen Text zu übertragen – ohne dass man es explizit programmieren oder trainieren müsste.

Wenn das Beispiel gut gewählt ist, funktioniert das in vielen Fällen erstaunlich zuverlässig.

Aber: Sobald die Sätze stilistisch stark abweichen oder zusätzliche Informationen enthalten, kann das Modell ins Straucheln geraten.

Dann wäre ein Wechsel auf Few Shot Prompting angebracht – darum geht es im nächsten Abschnitt.

Few Shot Prompting – Wenn ein Beispiel zu wenig ist

Sobald ein einziges Beispiel nicht mehr ausreicht, um die Aufgabe klar zu machen, kommt Few Shot Prompting ins Spiel.

Dabei erhält das Modell mehrere Beispiele – meist zwischen 2 und 10 –, die jeweils aus einer Eingabe und der dazugehörigen Ausgabe bestehen.

Das Ziel ist, dem Modell eine größere Bandbreite an Variationen zu zeigen, sodass es verlässlichere Muster erkennen und auf neue Eingaben übertragen kann.

Wann hilft Few Shot Prompting?

Few Shot Prompting ist besonders nützlich, wenn…

- die Eingaben inhaltlich stark variieren, aber das erwartete Format gleich bleibt

- die Aufgabe nicht klar durch ein einzelnes Beispiel erfassbar ist

- es auf feine Unterschiede oder implizite Regeln ankommt

- konsistente Formatierung oder Stiltreue gefordert ist (z. B. bei strukturierter Ausgabe)

- ein One Shot Prompt bereits brauchbar war, aber noch inkonsistent oder unpräzise arbeitet

Beispielhafte Anwendungsbereiche:

- Textklassifikation mit Zwischentönen („kritisch“, „neutral“, „wohlwollend“)

- Antwortgenerierung im Stil einer bestimmten Rolle (z. B. „PR-Sprecher“)

- Extraktion komplexer Informationen aus Freitext (z. B. Personen + Position + Kontext)

- Generierung von Listen, Tabellen oder Code-Snippets mit klarer Struktur

Beispiel: Kundenfeedback in Tonalitätsklassen einteilen

Ziel: Aussagen in drei Klassen einteilen: positiv, neutral, kritisch.

Prompt (Few Shot mit 3 Beispielen):

Feedback: "Ich bin wirklich begeistert vom neuen Feature!"

Kategorie: positiv

Feedback: "Die Idee ist gut, aber die Umsetzung hakt noch an mehreren Stellen."

Kategorie: kritisch

Feedback: "Das Update war okay, aber nichts Besonderes."

Kategorie: neutral

Feedback: "Ich weiß nicht, ob das Tool in der Praxis bestehen kann."

Kategorie:

➡️ Das Modell erkennt nun nicht nur das Format, sondern auch die Bandbreite der Tonalitäten – von stark positiv über verhalten neutral bis zu deutlicher Kritik.

Worauf es ankommt: Qualität statt Quantität

Mehr Beispiele sind nur dann hilfreich, wenn sie:

- repräsentativ für das erwartete Anwendungsspektrum sind

- konsistent im Aufbau und Stil präsentiert werden

- nicht redundant, aber auch nicht zu heterogen sind

Ein häufiger Fehler ist es, beliebige Beispiele „anzuhängen“, in der Hoffnung, das Modell dadurch schlauer zu machen.

In Wirklichkeit kann ein zu langer oder inkonsistenter Prompt sogar zu schlechteren Ergebnissen führen – z. B. weil das Modell wichtige Teile abschneidet (Kontextlimit) oder sich an einem unklaren Beispiel orientiert.

Technische Grenze: Das Kontextfenster

Große Sprachmodelle haben ein begrenztes Kontextfenster – also eine maximale Menge an Text, die sie auf einmal „sehen“ können.

Bei GPT-4 sind das z. B. 8.000 oder 32.000 Tokens, je nach Variante. Zu viele Beispiele, besonders wenn sie lang sind, können das Fenster schnell füllen – und damit den Raum für die eigentliche Aufgabe einschränken.

Few Shot Prompting ist ein wirkungsvolles Werkzeug, wenn es richtig eingesetzt wird. Es bietet dem Modell die Möglichkeit, Muster zu erkennen, Formatierungen zu lernen und sich an Nuancen zu orientieren.

Aber: Die Auswahl und Gestaltung der Beispiele entscheidet über den Erfolg – nicht bloß ihre Anzahl.

Im nächsten Abschnitt vergleichen wir die beiden Strategien direkt – und klären, wie sich One Shot und Few Shot konkret unterscheiden.

Direktvergleich: Was unterscheidet die beiden – und warum ist das wichtig?

One Shot und Few Shot Prompting gehören zur gleichen Familie – beide nutzen Beispiele im Prompt, um dem Sprachmodell eine Aufgabe zu verdeutlichen.

Der zentrale Unterschied liegt in der Anzahl der Beispiele. Aber das allein erklärt noch nicht, wie sich beide Techniken im Verhalten unterscheiden – und was das für die Praxis bedeutet.

Überblick: One Shot vs. Few Shot auf einen Blick

| Merkmal | One Shot Prompting | Few Shot Prompting |

|---|---|---|

| Anzahl Beispiele | 1 | 2–10 (typisch) |

| Format-Lerneffekt | hoch | sehr hoch (mit Variationen) |

| Robustheit bei Varianz | gering | deutlich höher |

| Aufwand für Erstellung | niedrig | höher (mehr Beispiele formulieren) |

| Platzverbrauch im Prompt | gering | höher (Kontextgrenze beachten) |

| Fehleranfälligkeit | bei ambivalentem Beispiel hoch | bei inkonsistenter Auswahl hoch |

| Geeignet für… | einfache, klar strukturierte Aufgaben | komplexe, nuancenreiche Aufgaben |

Warum das wichtig ist

Die Wahl zwischen One Shot und Few Shot ist keine rein technische Entscheidung, sondern hat direkten Einfluss auf:

- die Verständlichkeit der Aufgabe für das Modell

- die Qualität und Konsistenz der Ausgaben

- die Art, wie man selbst Prompts entwirft und testet

One Shot eignet sich gut, wenn das Beispiel allein schon selbsterklärend ist und die Aufgabe kaum Varianz aufweist – etwa bei strukturierten Extraktionen oder binären Entscheidungen.

Few Shot entfaltet seine Stärke, wenn das Modell zwischen Varianten unterscheiden soll oder wenn es darum geht, implizite Regeln zu erkennen – etwa Tonalitäten, Stile oder uneinheitliche Formulierungen.

Ein weiteres Kriterium: Kognitiver Fokus.

Mit One Shot steuert man das Modell stärker: „So sieht das aus, mach’s genauso.“

Mit Few Shot erlaubt man dem Modell, über Beispiele zu abstrahieren: „So ähnlich kann das aussehen – versteh den Rahmen.“

Und was bedeutet das für die Praxis?

Wer regelmäßig mit KI-Modellen arbeitet, merkt schnell: Die Entscheidung für One Shot oder Few Shot beeinflusst nicht nur die Ergebnisse, sondern auch den Prompting-Stil.

- In frühen Testphasen kann ein One Shot Prompt genügen, um die grundsätzliche Richtung zu prüfen.

- In der produktiven Nutzung ist Few Shot oft stabiler – wenn die Beispiele konsistent und wohlüberlegt sind.

- Bei begrenztem Platz (z. B. API-Calls mit kleinem Kontextfenster) ist One Shot oft die pragmatischere Wahl.

Im nächsten Abschnitt gehen wir tiefer in die Frage: Wann funktioniert welche Technik wirklich gut – und woran erkennt man das? Denn Theorie ist das eine – aber am Ende zählt, was im Alltag trägt.

Wann funktioniert welche Technik am besten?

Die Entscheidung zwischen One Shot und Few Shot Prompting lässt sich selten pauschal treffen.

Sie hängt stark von der konkreten Aufgabe, der gewünschten Ausgabe und dem Verhalten des Modells ab.

Dennoch lassen sich aus der Praxis klare Orientierungspunkte ableiten, die helfen, den passenden Ansatz zu wählen.

Drei Leitfragen zur Einschätzung

- Wie groß ist die Varianz der Eingaben?

Wenn die Texte sehr ähnlich sind (z. B. immer Produktbeschreibungen), kann ein gutes One Shot Prompt oft reichen. Bei breitem Spektrum (z. B. Nutzerkommentare, Fragen aus unterschiedlichen Domänen) sind mehrere Beispiele sinnvoll. - Wie eindeutig ist das erwartete Format?

Wenn die Ausgabe immer gleich strukturiert ist (z. B. immer eine Zahl, ein Label, ein JSON-Block), kommt One Shot gut klar. Wenn Format und Sprache variieren dürfen oder müssen, hilft Few Shot beim Verstehen des Rahmens. - Wie viel Interpretationsspielraum gibt es?

Je offener die Aufgabe (z. B. Tonfall erkennen, Aussagen bewerten), desto eher sollte man mit mehreren Beispielen arbeiten, um das Modell zu „kalibrieren“.

Zwei Szenarien aus dem Berufsalltag

Beispiel 1: Keyword-Klassifikation für Blogartikel

Aufgabe: Einem Textabschnitt sollen passende Kategorien zugewiesen werden, etwa „Technologie“, „Marketing“, „Leadership“.

→ Hier reicht oft ein One Shot Prompt, wenn das Beispiel klar zeigt, wie viele und welche Kategorien möglich sind.

Aber: Sobald die Themen verschwimmen oder Zwischenformen entstehen („digitale Führung“), wird Few Shot verlässlicher.

Beispiel 2: Tonalitätsanalyse von E-Mails

Aufgabe: Rückmeldungen von Kunden sollen in „positiv“, „neutral“ oder „kritisch“ eingestuft werden.

→ Die Formulierungen sind oft uneindeutig oder ironisch.

→ Few Shot Prompting hilft hier enorm, da es dem Modell ein besseres Gespür für Zwischentöne vermittelt.

Typische Denkfehler vermeiden

- „Ein Beispiel ist besser als keins – also reichen eins oder zwei immer.“

Nicht unbedingt. Ein schlecht gewähltes Beispiel bringt mehr Schaden als Nutzen. - „Mehr Beispiele sind automatisch besser.“

Auch das ist trügerisch. Zu viele Beispiele können das Modell überfordern oder wichtige Teile des Prompts verdrängen. - „Ich kopiere einfach frühere Beispiele.“

Funktioniert nur, wenn die alten Beispiele wirklich zum neuen Anwendungsfall passen.

Eine pragmatische Empfehlung

- Teste zuerst One Shot, wenn die Aufgabe klar ist.

- Steig auf Few Shot um, wenn:

- die Ergebnisse schwanken

- wichtige Details übersehen werden

- Format oder Stil nicht eingehalten werden

- Halte die Beispiele konsistent – in Sprache, Struktur und Länge.

Im nächsten Abschnitt geht es darum, wie stark das Format selbst die Modellleistung beeinflusst – unabhängig von der Anzahl der Beispiele.

Denn auch ein „perfekter Prompt“ kann scheitern, wenn die Formatierung nicht stimmt.

Warum Format, Reihenfolge und Konsistenz so entscheidend sind

Ob One Shot oder Few Shot – in beiden Fällen hängt der Erfolg stark davon ab, wie die Beispiele gestaltet sind.

Dabei geht es nicht nur um den Inhalt, sondern ganz wesentlich um das Format: also Struktur, Reihenfolge, Sprache und Konsistenz der Beispiele im Prompt.

Große Sprachmodelle sind extrem aufmerksam für formale Muster – manchmal sogar mehr als für inhaltliche Bedeutungen.

Deshalb beeinflusst das äußere Erscheinungsbild eines Prompts oft stärker die Ausgabe als der tatsächliche Textinhalt.

Beispiel: Gleiche Aufgabe, unterschiedliches Format

Ziel: Text in „positiv“ oder „negativ“ klassifizieren.

Prompt A – unsauber formatiert:

"Ich liebe das neue Design!" → Pos

"Der Kundenservice war unterirdisch." => negativ

"Kann ich nicht empfehlen." : negativ

"Endlich mal eine intuitive Bedienung."

➡️ Unklare Trennzeichen, uneinheitliche Schreibweise, Mischformate – das Modell hat keine stabile Struktur zum Nachvollziehen.

Prompt B – konsistent formatiert:

Text: "Ich liebe das neue Design!"

Label: positiv

Text: "Der Kundenservice war unterirdisch."

Label: negativ

Text: "Kann ich nicht empfehlen."

Label: negativ

Text: "Endlich mal eine intuitive Bedienung."

Label:

➡️ Gleiches Format, klare Labels, nachvollziehbarer Aufbau – deutlich höhere Wahrscheinlichkeit für konsistente Ergebnisse.

Drei Faktoren, die das Format beeinflussen

- Klarheit der Struktur

Nutze immer dieselbe Reihenfolge von Ein- und Ausgabe. Keine Mischung aus Pfeilen, Strichen oder Satzzeichen. Wenn du „Frage – Antwort“ verwendest, dann durchgehend. - Konsequente Benennung und Formatierung

Schreib Labels immer gleich: nicht einmal „Pos“, einmal „positiv“, einmal „+“. Gleiches gilt für Formatierungen (z. B. immer „Frage: … / Antwort: …“). - Reihenfolge der Beispiele

Die Reihenfolge kann Einfluss nehmen – vor allem, wenn Beispiele unterschiedlich gewichtet erscheinen. Es ist oft sinnvoll, mit einem besonders typischen Beispiel zu starten und seltenere Fälle später zu bringen.

Format schlägt Inhalt – manchmal

Ein kurioser, aber gut belegter Effekt: Selbst falsch gelabelte Beispiele, die aber im richtigen Format präsentiert werden, können das Modell zu brauchbaren Ergebnissen führen.

Umgekehrt können inhaltlich korrekte Beispiele mit schlechtem Format zu Verwirrung führen.

Das bedeutet:

▶️ Die äußere Form ist ein starkes Steuerungssignal – oft stärker, als man intuitiv annimmt.

Mini-Checkliste: Ist dein Prompt gut formatiert?

- ✅ Sind Ein- und Ausgaben klar voneinander getrennt?

- ✅ Ist das Format in allen Beispielen gleich?

- ✅ Sind die Labels konsistent benannt?

- ✅ Beginnt der Prompt mit einem typischen Beispiel?

- ✅ Gibt es keine unnötigen Formatvariationen (z. B. mal Anführungszeichen, mal nicht)?

Wenn hier Unsicherheit besteht, lohnt es sich fast immer, den Prompt zu überarbeiten – oft mit messbar besseren Ergebnissen.

Im nächsten Abschnitt ordnen wir diese Techniken in den größeren Zusammenhang ein: Wie verhalten sich One Shot und Few Shot Prompting zu Zero Shot – und was kommt danach?

Verbindung zu Zero Shot und Chain-of-Thought

One Shot und Few Shot Prompting sind zwei Varianten innerhalb des sogenannten In-Context Learning – also der Fähigkeit großer Sprachmodelle, aus Beispielen im Prompt zu lernen.

Doch das Spektrum beginnt noch früher: bei Zero Shot Prompting.

Zero Shot: Die minimalistische Variante

Beim Zero Shot Prompting wird dem Modell kein Beispiel mitgegeben – nur eine Anweisung in natürlicher Sprache.

Beispiel:

Bestimme, ob der folgende Satz positiv oder negativ gemeint ist:

"Ich finde das Produkt enttäuschend."

➡️ Das Modell muss auf Basis seines allgemeinen Weltwissens und der sprachlichen Formulierung entscheiden, was zu tun ist.

Vorteile:

- Schnell und effizient

- Kein Aufwand für Beispielsammlung

- Oft ausreichend bei klaren, eng gefassten Aufgaben

Nachteile:

- Unpräzise bei offenen oder mehrdeutigen Aufgaben

- Keine Möglichkeit, Format oder Stil direkt zu steuern

- Anfällig für Missverständnisse oder ungewollte Interpretationen

Zero Shot ist damit vor allem dann sinnvoll, wenn…

- die Aufgabe sprachlich selbsterklärend ist

- keine Formatierung gefordert wird

- ein schneller erster Versuch ausreicht

Chain-of-Thought: Denkmuster statt Beispiele

Während Zero, One und Few Shot auf Beispiele setzen, geht das Chain-of-Thought Prompting (CoT) einen anderen Weg: Statt Beispielen liefert man dem Modell eine strukturierte Denkanleitung, die es zur Lösung führen soll.

Beispiel:

Frage: Wenn ein Apfel 30 Cent kostet und eine Banane 20 Cent, wie viel kosten zwei Äpfel und eine Banane zusammen?

Antwort:

Ein Apfel kostet 30 Cent. Zwei Äpfel kosten also 2 × 30 = 60 Cent.

Eine Banane kostet 20 Cent.

Zusammen ergibt das 60 + 20 = 80 Cent.

Antwort: 80 Cent

➡️ Das Modell wird durch die strukturierte Zwischenschritte dazu gebracht, nicht nur das Endergebnis zu liefern, sondern den Lösungsweg nachzuvollziehen.

CoT eignet sich besonders für:

- Rechenaufgaben

- logisches Schließen

- Aufgaben mit mehreren Bedingungen oder Regeln

In der Praxis kann man Chain-of-Thought sogar mit Few Shot kombinieren – also mehrere Beispiele liefern, die jeweils einen Denkvorgang zeigen.

Zero Shot, One Shot, Few Shot und Chain-of-Thought sind keine konkurrierenden Methoden, sondern Ergänzungen im Werkzeugkasten des Promptings.

Je nach Aufgabe, Zielsetzung und gewünschter Kontrolle lässt sich die passende Technik wählen – oder kreativ kombinieren.

Im abschließenden Kapitel ziehen wir noch einmal Bilanz: Was bleibt hängen – und wie kann man dieses Wissen im Alltag konkret anwenden?

Fazit: One Shot, Few Shot – und alles dazwischen

Prompting ist keine exakte Wissenschaft, sondern ein situatives Handwerk. Ob One Shot oder Few Shot die bessere Wahl ist, hängt nicht allein von der Technik ab, sondern vom Zusammenspiel aus Aufgabe, Erwartung und Gestaltung.

Drei Dinge lassen sich festhalten:

- Ein gutes Beispiel wirkt – aber nur, wenn es klar, konsistent und passend ist.

- Mehrere Beispiele helfen, wenn Variabilität im Spiel ist – aber sie müssen gezielt ausgewählt sein.

- Das Format ist kein Nebenschauplatz – es ist ein zentrales Steuersignal für das Modell.

Zero Shot, One Shot, Few Shot, Chain-of-Thought – all diese Techniken sind keine Entweder-Oder-Optionen, sondern Elemente eines flexiblen Werkzeugkastens.

Wer damit arbeitet, tut gut daran, nicht nur zu fragen: „Wie viele Beispiele?“, sondern auch:

- „Wie genau will ich das Modell führen?“

- „Was braucht es, damit das Modell meine Absicht erkennt?“

- „Wo liegt eigentlich die Unsicherheit – bei mir oder bei der KI?“

Die gute Nachricht: Es gibt Raum zum Experimentieren. Sprachmodelle reagieren sensibel – und genau das ist ihre Stärke.

Wer Prompting ernst nimmt, bekommt ein leistungsfähiges Instrument an die Hand, das sich mit wenig Aufwand erstaunlich präzise steuern lässt.

Der Rest ist Erfahrung – und Neugier.

Prompting-Vergleiche im Überblick

Im Prompting Hub für Content-Ersteller findest du eine vollständige Übersicht mit Methoden, Vergleichen und Entscheidungshilfen.

Welche Technik passt zu welcher Aufgabe? In dieser Reihe vergleiche ich verschiedene Prompting-Methoden – jeweils mit Beispielen und klarer Entscheidungshilfe:

- Zero-Shot vs One-Shot Prompting

Wann reicht eine gute Anweisung – und wann braucht das Modell ein Beispiel? - One-Shot vs Few-Shot Prompting

Wie viele Beispiele machen den Unterschied – und worauf kommt es wirklich an? - Few-Shot vs Chain-of-Thought Prompting

Ergebnis vormachen oder Denkprozess zeigen? Zwei Techniken für unterschiedliche Anforderungen. - Chain-of-Thought vs Tree-of-Thought Prompting

Linear denken oder systematisch verzweigen? Wann sich strukturierte Gedankengänge lohnen – und wann ein Modell mehrere Lösungswege braucht.